NVIDIA подвоює швидкість навчання глибоких нейронних мереж .

NVIDIA подвоює швидкість навчання глибоких нейронних мереж

ЛІЛЛЬ, Франція—ICML—7 липня, 2015 — NVIDIA оголосила про оновлення бібліотек з алгоритмами глибокого навчання (deep learning) з підтримкою GPU-прискорення. Нова версія дозволяє подвоїти швидкість навчання нейронних мереж.

Більш точні нейронні мережі завдяки прискореному навчанню моделей і їх більш складній структурі дозволять вченим і дослідникам прискорити роботу над проектами, пов'язаними з глибоким навчанням.

Система глибокого навчання NVIDIA

DIGITS 2 тепер дозволяє автоматично масштабувати навчання нейронних мереж на кілька високопродуктивних графічних процесорів. Для задач класифікації зображень це дозволить скоротити час навчання мережі вдвічі (порівняно з системою на базі одного GPU).

cuDNN 3 дозволяє оптимізувати зберігання даних в пам'яті GPU при навчанні більш складних нейронних мереж. cuDNN 3 також забезпечує приріст продуктивності в порівнянні з версією cuDNN 2, дозволяючи дослідникам навчати нейронні мережі до двох разів швидше, ніж на системах з одним GPU.

Очікується, що нова бібліотека cuDNN 3 буде інтегрована в нові версії фреймворків глибокого навчання Caffe, Minerva, Theano та Torch, які широко застосовуються для навчання глибоких нейронних мереж.

«Сьогодні високопродуктивні графічні процесори знаходяться в основі дослідних проектів по глибокому навчання і розробки продуктів як в наукових організаціях, так і у великих інтернет-компаніях, - говорить Ян Бак (Ian Buck), віце-президент з високопродуктивних обчислень NVIDIA. – Ми тісно співпрацюємо з фахівцями з обробки даних, розробниками фреймворків та спільнотою глибокого навчання - застосовуємо найбільш потужні графічні рішення і змінюємо уявлення про можливий».

DIGITS 2 – навчання стає вдвічі швидше завдяки автоматичного масштабування на кілька GPU

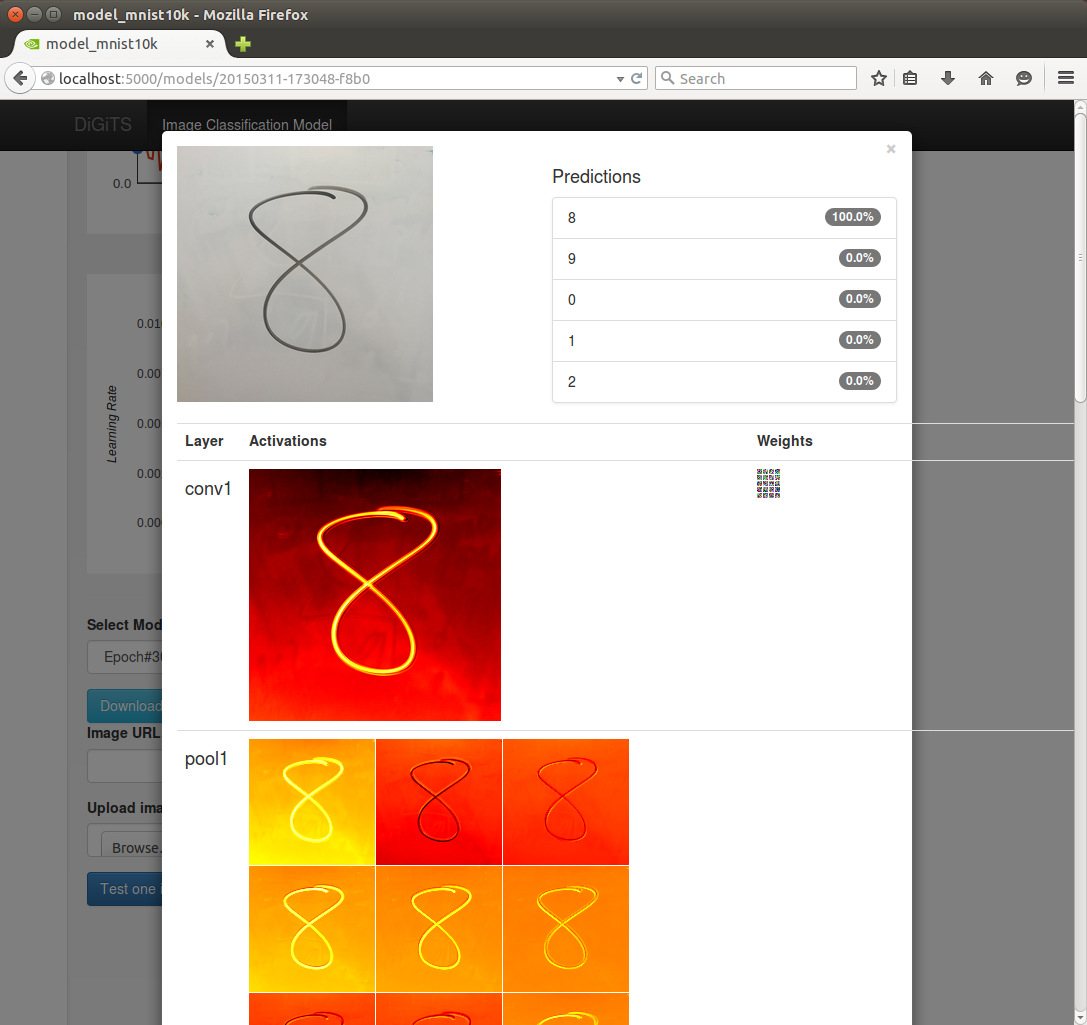

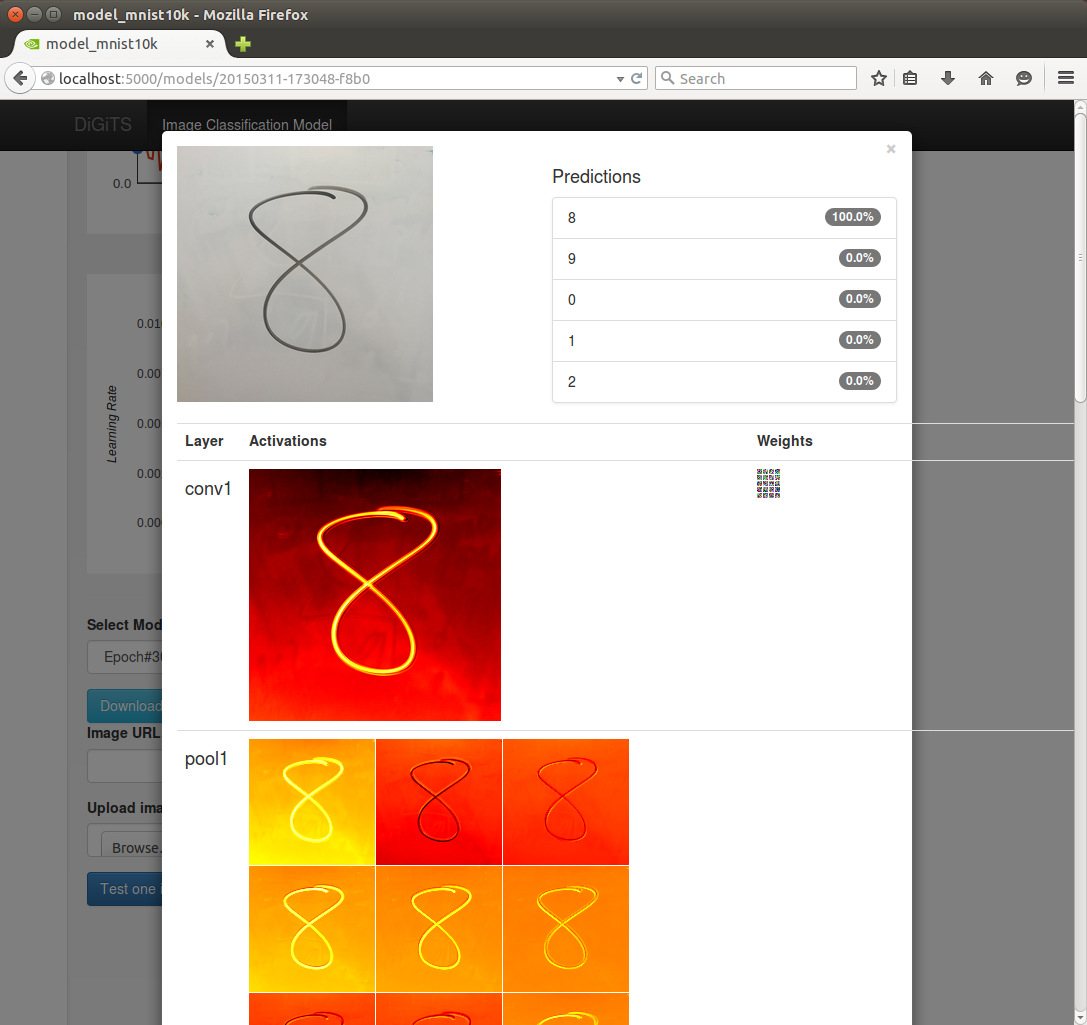

DIGITS 2 – це перша повнофункціональна система з графічним інтерфейсом, яка допомагає користувачам проектувати, навчати і тестувати мережі глибокого навчання в задачах класифікації зображень.

Підтримка автоматичного масштабування на кілька GPU в DIGITS 2 максимально повно використовує ресурси системи завдяки автоматичному розподілу навантаження між графічними процесорами системи. З допомогою DIGITS 2, на системі на базі чотирьох GPU на базі архітектури NVIDIA Maxwell™, інженери NVIDIA навчили широко відому нейронну мережу AlexNet в два рази швидше, ніж на системі на базі одного GPU (Продуктивність DIGITS 2 в порівнянні з попередньою версією в системі NVIDIA DIGITS DevBox з графічними процесорами NVIDIA GeForce GTX TITAN X.)

І це не межа. Замовники компанії, які вже отримали можливість випробувати нову версію системи, змогли досягти навіть кращих результатів.

«Навчання однієї з наших глибоких мереж для автоматичного додавання позначок на одному NVIDIA GeForce GTX Titan X займає приблизно шістнадцять днів. З новою системою автоматичного масштабування при використанні чотирьох процесорів Titan X процес скоротився до п'яти днів, - говорить Саймон Осиндеро (Simon Osindero), архітектор систем штучного інтелекту для Yahoo Flickr. – Це велика перевага, воно дозволяє нам швидше отримувати результати, а також більш масштабно досліджувати простір моделей для отримання більш точних результатів».

cuDNN 3 – навчання більш великих і складних моделей стає швидше

cuDNN – це GPU-експрес бібліотека математичних операцій для глибоких нейронних мереж, яку розробники вбудовують у фреймворки машинного навчання високого рівня.

У cuDNN 3 додана підтримка зберігання 16-бітних даних з плаваючою точкою в пам'яті GPU, що подвоює обсяг збереженої інформації і оптимізує використання пропускної здатності пам'яті. Завдяки цьому дослідники можуть навчати більш складні нейронні мережі.

«Ми впевнені, що підтримка FP16 для зберігання даних в пам'яті GPU в бібліотеках NVIDIA дозволить нам ще більше масштабувати наші моделі, так як це збільшить ефективний об'єм пам'яті нашої системи і підвищить ефективність масштабування навчання нейронної мережі на кілька графічних процесорів, - говорить Брайан Катанзаро (Bryan Catanzaro), старший дослідник в Baidu Research. – У підсумку, точність наших моделей зросте ще більше».

cuDNN 3 також забезпечує вагомий зростання продуктивності в порівнянні з cuDNN 2 при навчанні нейронних мереж на одному GPU. Так, з новою версією інженери NVIDIA змогли навчити мережу AlexNet в два рази швидше на системі на базі GPU NVIDIA GeForce® GTX™ TITAN X (Продуктивність cuDNN 3 у порівнянні з попередньою версією на Ubuntu 14.04 LTS з GPU NVIDIA GeForce TITAN X і Intel Core i7-4930K @ 3.40GHz).

Доступність

Предфинальная версія DIGITS 2 вже доступна для безкоштовного завантаження для зареєстрованих розробників NVIDIA. Детальніше дивіться на сайті DIGITS.

Бібліотека cuDNN 3 буде доступна у великих інфраструктурах глибокого навчання в найближчі місяці. Детальніше дивіться на сайті cuDNN.

Про компанії NVIDIA

NVIDIA (NASDAQ: NVDA) знаходиться на вершині мистецтва і науки візуальних обчислень з 1993 року. Технології компанії перетворюють світ зображень у світ інтерактивних відкриттів для самих різних користувачів — геймерів і вчених, користувачів мобільних пристроїв, офісних працівників і не тільки. Детальніше дивіться на сайтах http://www.nvidia.ru, http://nvidianews.nvidia.com і http://blogs.nvidia.com.

.

До списку

|